Vers une société humaine et robotique

2017/06/01 Etxebeste Aduriz, Egoitz - Elhuyar Zientzia Iturria: Elhuyar aldizkaria

400

400

Il y a 65 ans, l'écrivain Isaac Asimov a présenté dans le conte Runaround trois lois pour la robotique: 1) Le robot ne nuira pas à l'être humain et empêchera l'homme d'être endommagé; 2) le robot exécutera les ordres donnés par l'homme, sauf s'il s'oppose à la première loi; et 3) le robot s'autoprotégera s'il ne va pas contre la première et deuxième loi.

Asimov a incarné des personnes et des robots dans leurs récits de science-fiction, et pour cette coexistence, il a vu nécessaire de programmer les robots selon ces lois. Mais ce monde n'est plus si fictif : les véhicules autonomes, les drones, les robots pour aider les personnes âgées et les handicapés, tous ceux qui entrent dans l'industrie et les machines capables d'apprendre.

« Il est indéniable qu’une révolution se produit », explique Elena Lazkano Ortega, chercheuse au département de Science de l’Informatique et de l’Intelligence Artificielle de l’UPV. Cependant, la vitesse de cette révolution n'est pas aussi claire: «Parfois, il me semble qu’il est là, qu’il nous vient dessus, et parfois les progrès sont énormément lents.» Gorka Azkune Galparsoro, chercheur en intelligence artificielle à Deustotech-Deusto: « Du point de vue de l’intelligence artificielle, il y a eu un grand saut qui n’a pas été vu depuis de nombreuses années. Il est très difficile de prévoir à quel point les choses vont changer, mais je pense que d’ici pas trop d’années, cela va avoir une grande influence sur notre vie.»

Face à cette situation, il faudra plus que les lois d'Asimov, et des pays comme les États-Unis, la Chine, le Japon ou l'Union européenne ont déjà commencé à traiter la question. Azkune estime que dans certains cas, les législations sont déjà nécessaires. « Par exemple, aux États-Unis, plusieurs États développent des législations sur les véhicules autonomes. Cette technologie est déjà très mature.» Mais il voit aussi le danger de trop avancer dans les législations: « J’ai peur de limiter les développements législatifs possibles. Il faut se préparer, c’est clair, mais je ne sais pas à quel point on peut avancer.» Eh bien, pour bien faire les choses, Lazkano voit nécessaire un débat profond: « C’est un débat dans lequel nous devons tous participer, industrie, universités et même société. Nous ne pouvons pas laisser les gouvernements seuls faire une législation ».

En février dernier, le Parlement européen a demandé à la Commission européenne de proposer des lois pour la robotique et l'intelligence artificielle. Cette demande était basée sur l'étude des lois civiles de la robotique prises par la Commission des affaires européennes de droit. En Grande-Bretagne, l'Organisation britannique BSI Standard a également lancé l'année dernière les normes pour la conception éthique des robots. Comme une mise à jour des lois d'Asimov, ils ont également souligné trois points généraux: 1) Les robots ne doivent pas être conçus seul ou principalement pour tuer les humains; 2) Les responsables des actions des robots sont humains, non robots; et 3) Il doit être possible de savoir qui est responsable de chaque robot et de ses actions.

En plus de la sécurité des gens, ils ont mis l'accent sur les préoccupations. Lazkano y correspond: « Les robots sont conçus par nous et pour le moment par les robots. Et dans la mesure où cela est le cas, nous sommes responsables. Par exemple, les véhicules autonomes ont besoin pour le moment d'un superviseur. L'acheteur de la voiture l'achètera dans des conditions et, en cas d'accident, s'il a respecté ces conditions, le responsable sera le concepteur, et s'il n'a pas respecté les conditions, l'utilisateur. Nous ne pouvons pas vous tromper. Ce serait nous justifier”.

Capacité d'apprentissage

Mais, selon Azkun, il peut ne pas toujours être aussi propre. « On pense souvent que les robots sont programmés pour faire une chose. Mais aujourd'hui, les robots sont capables d'apprendre et probablement plus à l'avenir. Et la capacité d'apprentissage peut générer une autonomie de décision. Alors, comme ces robots apprennent eux-mêmes, qui est responsable de ce qu'ils apprennent? En définitive, s’ils apprennent de nous, nous serons responsables, mais cette responsabilité peut devenir très diluée dans la société».

Comparez ce qui se passe avec les gens: « Au début, un enfant ne sait rien. S'il devient alors un meurtrier, à qui correspond ? Bien sûr, la société a fait quelques erreurs, ou les autres... Dans ce cas, cette personne est blâmée. Alors il faudra le voir... D’un point de vue déterministe ou programmatique, il peut être plus facile, mais l’intelligence artificielle est gratuite, et avec la force que vous acquérez l’apprentissage, ces choses ne peuvent probablement pas être résolues si facilement.»

Cependant, la capacité d'apprentissage de l'intelligence artificielle reste limitée. « Pour le moment, ils saisissent des données, apprennent ce qu’ils contiennent et n’ont qu’une certaine capacité de généralisation », explique Lazkano. « Ainsi, si les données qui leur sont fournies sont éthiques, les sorties seront également éthiques. » Mais, bien sûr, il ne sera pas toujours facile que les données qui leur sont fournies soient éthiques, par exemple en utilisant des données Internet. La preuve en est ce qui s'est passé avec le chat Microsoft Tay: Ils se sont mis sur Twitter et ont dû retirer les commentaires racistes, sexistes, nazis, etc. en 24 heures. Bien sûr, il a appris des interviews sur twitter.

« On appelle cela le problème du monde ouvert », affirme Azkun. « Si nous ouvrons le monde aux intelligences artificielles et laissons toutes les données être prises, des problèmes pourraient survenir. Cela peut être contrôlé, mais jusqu’à quand voulons-nous que ces intelligences deviennent de plus en plus puissantes ? » Comme la capacité d'apprendre augmente, les choses pourraient changer. “La Deep Mind de Google parle déjà de l'intelligence artificielle”, affirme Azkune. Une intelligence artificielle générale serait en mesure de prendre des décisions par elle-même. « Aujourd’hui, l’intelligence artificielle est assez contrôlée en fonction des données et de la technique d’apprentissage que vous utilisez, mais au fur et à mesure que vous avancez et que vous avez plus de liberté pour décider de ces intelligences, il ne sera pas si facile de contrôler ce que vous pouvez apprendre. »

Mais Azkun précise que cela est loin de se produire: « Ces dernières années, de grands progrès ont eu lieu, et si nous les projetons vers l’avenir, un monde assez différent pourrait apparaître, mais nous ne sommes pas encore si avancés en ce sens. Nous sommes encore au niveau de la spécialisation: nous avons de petites intelligences qui sont très bonnes à faire des choses concrètes, mais cette généralité qui a l'être humain ne semble pas proche. Il est vrai que précisément cette année, de petits progrès ont été accomplis dans l'intelligence générale. Mais nous sommes encore dans une recherche très basique, qui peut arriver, mais nous ne savons pas”.

Mains humaines

Lazkano est clair que les robots sont éthiques aux mains des humains. « Si nous ne leur enseignons pas des comportements éthiques, les robots que nous fabriquons n’auront pas de comportement éthique. » Et nous ne devons pas oublier ce qu'ils sont. « Nous devons certainement penser à quelle utilisation nous voulons vous donner. Mais ce ne sont que des outils. Des outils pour faire mille choses, aussi pour parler, mais ce sont des outils ».

Azkun a également souligné cette perspective. “Nous devons garder à l'esprit que, comme toute technologie, vous pouvez avoir des inconvénients, et vous devez essayer de les prévenir, mais ne pas avoir peur. Cette technologie est encore à développer, car nous pensons comment nous l'avons utilisée pour résoudre des problèmes réels. Par exemple, l'intelligence artificielle a déjà été utilisé pour détecter le cancer de la peau et le rend mieux que l'homme. Il pourrait y avoir mille autres cas. La thérapie contre le cancer ou le nouveau médicament peut générer de l'intelligence artificielle ou prédire son effet. Nous devrions penser à ces choses. Comment pouvons-nous utiliser ces nouveaux pouvoirs pour faire face aux problèmes que nous avons. Mais, bien sûr, il faut toujours penser que cela ne doit pas devenir un problème ».

Par exemple, si la création de liens émotionnels avec les robots peut devenir un problème, par exemple. Lazkano considère que cela est inévitable: « Le fétichisme est le propre. Nous avons tendance à créer des liens émotionnels avec les objets et avec les robots égaux ». Et il peut souvent être pour le bien: “Diverses recherches ont montré que les liens émotionnels avec les enfants autistes, les personnes âgées et d'autres avec les robots sont bénéfiques pour eux. Par exemple, les plus âgés qui vivent seuls apprécient beaucoup d'avoir un robot à la maison et, bien qu'aujourd'hui ils soient très limités, on a vu qu'un lien émotionnel est créé avec ces robots, ce qui est bon pour eux. Ils se sentent plus en sécurité à la maison, sont mieux émotionnellement, etc. Dans d’autres cas, cela peut être un problème, mais cela a aussi des avantages.»

Et un autre problème qui inquiète, et qui peut être plus proche, est l'élimination des emplois par les robots. « Il y a des emplois à perdre, mais ces travailleurs peuvent effectuer d’autres travaux et les robots peuvent créer de nouvelles professions », explique Lazkano. « Je ne sais pas à quel point ce sera violent. Cette peur nous a mis dans d’autres révolutions industrielles.»

Azkune correspond: « Cela s’est produit plusieurs fois dans notre histoire et je pense que peu à peu nous trouverons notre place. Il y aura toujours une phase de transition où les gens vont mal. Mais ne pensons pas que ces gens, comme on dit toujours, soient les gens moins formés. Je n'exclus pas du tout que l'intelligence artificielle soit capable de créer des théories, de poser des preuves et des expériences, etc., et dans ce cas, d'enlever beaucoup de travail aux scientifiques. Nous ne savons pas dans quel sens vont venir les changements et il nous revient à tous de s’adapter à eux ».

« Et si une société vient où tout est automatisé et que l’homme n’a pas à travailler, cela ne me semble pas négatif », a ajouté Azkune. « Nous devrons évoluer vers un autre type de société ».

Une société de personnes et de robots

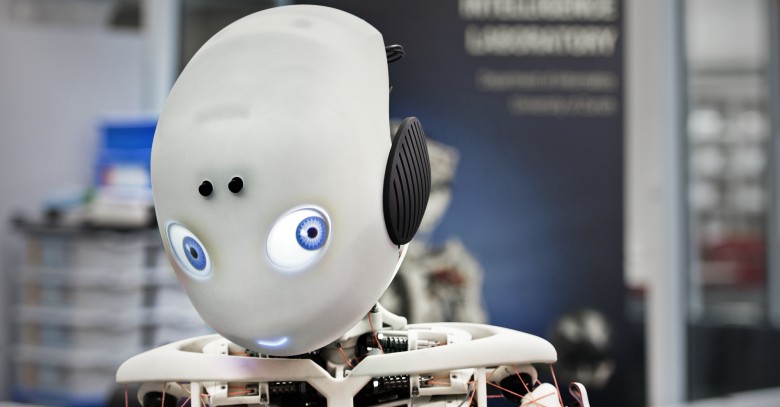

Cette possible société serait une société de personnes et de robots. Lazkano estime que dans une dizaine d'années les robots peuvent être dans les maisons, mais de là que les robots font partie de la société il y a une sangria. « Peut-être viendra-t-il. Une des clés les plus importantes serait d'obtenir notre capacité de dialogue. Et il y a des machines capables de maintenir une conversation cohérente pendant quelques minutes, mais vous vous rendez vite compte que vous travaillez avec une machine. Jusqu'à ce que vous obtenez une machine à la maison, pas un ami ou autre”.

Il faudra voir à quel niveau arrivent les robots ou les intelligences artificielles. « Je suis clair que s’ils atteignent le niveau des êtres humains, ou qu’ils le dépassent, ils devront être traités comme des égaux en matière de responsabilités légales et éthiques. Si un robot commet un meurtre, il doit être jugé comme une personne ou avec des mécanismes similaires. Si nous reconnaissons qu'ils ont la liberté de décision et la capacité d'apprentissage, etc., nous devons les considérer comme égaux en ce sens. La clé est le niveau d'intelligence qui est atteint. Ils doivent être traités en conséquence. Actuellement, les animaux n'ont pas le même traitement que les humains, ni un enfant ni un adulte. Beaucoup de questions surgiront et il faudra beaucoup travailler, si cela arrive.»

Gai honi buruzko eduki gehiago

Elhuyarrek garatutako teknologia